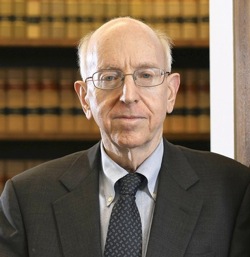

理查德。波斯纳是法学家、法律理论家和经济学家。他还写了近40本书,是迄今为止20世纪被引用最多的法律学者.

理查德。波斯纳是法学家、法律理论家和经济学家。他还写了近40本书,是迄今为止20世纪被引用最多的法律学者.

2004年波斯纳出版巨灾:风险与应对在这本书中,他讨论了风险美国国际集团在一些长度。他的分析之所以有趣,部分原因在于它似乎在智力上独立于今天主导这个话题的博斯特罗姆-尤多科夫斯基传统。

事实上,波斯纳没有出现了解I.J. Good (1970,1982)、艾德·弗雷德金(1979)、罗杰·克拉克(1993,1994)、Daniel Weld & Oren Etzioni (1994)、詹姆斯·吉普斯(1995)、布莱·惠特比(1996)、黛安娜·戈登(2000)、克里斯·哈珀(2000),或科林·艾伦(2000).他甚至不知道汉斯·莫拉维奇(1990,1999)、比尔乔伊(2000)、尼克·博斯特罗姆(1997;2003),或尤科斯基(2001).基本上,他似乎只知道雷·库兹韦尔(1999).

不过,波斯纳的很多分析与博斯特罗姆-尤多科夫斯基传统的基本观点是一致的:

[一类灾难性风险]包括……科学事故,例如涉及粒子加速器、纳米技术……和人工智能的事故。技术是这些风险的根源,因此减缓技术发展速度可能是正确的应对之策。

也许有一天,也许很快的某一天(几十年,而不是几百年),会出现拥有人类的机器人,[此后不久]将超过人类的智能……

人类可能会成为21世纪的黑猩猩,如果是这样的话,机器人对我们的用处和尊重可能就像我们对其他非人类的灵长类动物一样少……

一个机器人潜在的破坏性并不取决于它是否有意识或是否能够从事……除非经过精心编程,否则这些机器人可能会不加选择地破坏并攻击它们的创造者。

库兹韦尔说的很可能是对的,“一旦计算机达到了人类的智能水平,它必然会咆哮着超越它”……

一个主要的分歧似乎是波斯纳担心一种情况,即AGIs变得有自我意识,重新评估他们的目标,并决定不再“被一个愚蠢的物种摆布”。相反,Bostrom和Yudkowsky认为AGI将是危险的,不是因为它们将“反抗”人类,而是因为(大致上)使用所有可用的资源——包括人类生命所依赖的资源——对于强大的AGI可能拥有的几乎所有最终目标来说,是一个聚合的工具目标。(见如。博斯特罗姆2012.)

你喜欢这个帖子吗?你可以享受我们的另一个yabo app 的帖子,包括: